Apple tung nghiên cứu chứng minh: Cái gọi là suy luận của AI chỉ là ảo tưởng, giấc mơ về AGI vẫn còn rất xa vời

Nghiên cứu của Apple đặt ra một câu hỏi lớn về tương lai của AI: Liệu chúng ta có đang quá "phấn khích" về những khả năng hiện tại của các hệ thống này đến mức bỏ qua các hạn chế hiện tại của nó.

Trong một động thái có thể làm rung chuyển cả ngành công nghệ, Apple vừa công bố một nghiên cứu táo bạo với tiêu đề "Ảo tưởng về Tư duy" - một cuộc tấn công trực diện vào niềm tin rằng các mô hình AI hiện tại đã có khả năng suy luận thực sự.

Nghiên cứu này không chỉ đặt dấu hỏi lớn về khả năng của những siêu phẩm AI được ca ngợi như GPT-o1, Claude Thinking hay DeepSeek-R1, mà còn cho rằng giấc mơ về trí tuệ nhân tạo tổng quát (AGI) vẫn còn xa vời hơn nhiều so với những gì chúng ta tưởng tượng.

Thời điểm Apple tung ra nghiên cứu này không hề ngẫu nhiên. Chỉ vài ngày trước Hội nghị Nhà phát triển Toàn cầu (WWDC) ngày 9 tháng 6, khi kỳ vọng về những tiến bộ AI của Apple đang ở mức thấp, công ty đã chọn cách "tạt gậy nước lạnh" vào làn sóng phấn khích xung quanh khả năng suy luận của AI. Điều đặc biệt thú vị là Apple - công ty đang gặp khó khăn với Apple Intelligence và Siri 2.0 - lại là người đứng ra thách thức những tuyên bố về siêu năng lực của các đối thủ.

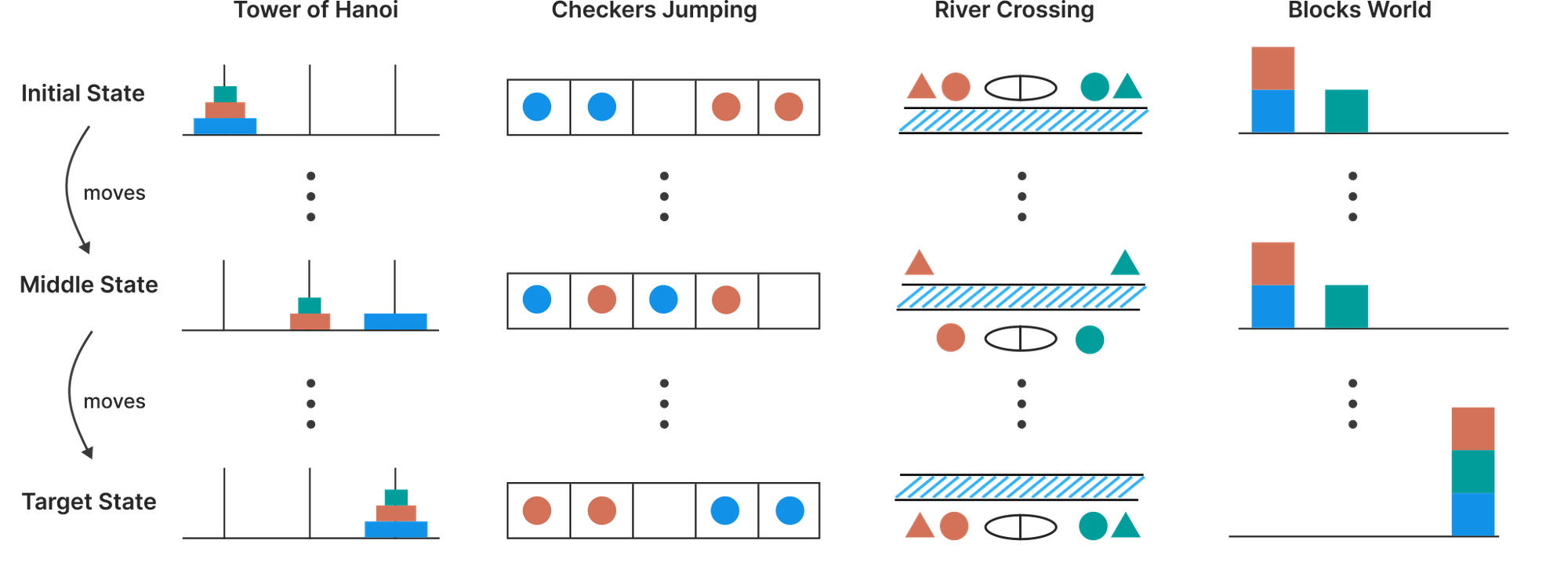

Để chứng minh luận điểm của mình, các nhà nghiên cứu Apple đã từ bỏ những cách đánh giá truyền thống mà thay vào đó tạo ra một phương pháp hoàn toàn mới. Thay vì sử dụng các bài kiểm tra toán học tiêu chuẩn - vốn có thể bị "nhiễm" do AI đã học từ dữ liệu trên internet - họ thiết kế ra những "môi trường giải đố có thể kiểm soát được". Đây là những trò chơi logic như Tháp Hà Nội, Checkers Jumping, River Crossing và Blocks World, nơi các nhà nghiên cứu có thể điều chỉnh độ khó một cách chính xác mà không làm thay đổi cấu trúc logic cốt lõi.

Cách tiếp cận này cho phép Apple không chỉ đánh giá kết quả cuối cùng mà còn "nhìn vào bên trong" quá trình suy nghĩ của AI, giống như việc theo dõi từng bước suy nghĩ của một học sinh khi giải bài toán. Và những gì họ phát hiện ra thực sự đáng kinh ngạc.

Các cột hiển thị tiến trình từ trạng thái ban đầu (trên cùng) qua trạng thái trung gian (giữa) đến trạng thái mục tiêu (dưới cùng) cho các câu đố: Tower of Hanoi (chuyển đĩa qua các chốt), Checkers Jumping (hoán đổi vị trí các quân cờ màu), River Crossing (vận chuyển các thực thể qua sông) và Blocks World (cấu hình lại ngăn xếp).

Kết quả nghiên cứu cho thấy các mô hình AI suy luận hoạt động theo ba "chế độ" hoàn toàn khác nhau tùy thuộc vào độ phức tạp của bài toán. Với những vấn đề đơn giản, một điều bất ngờ đã xảy ra: các mô hình AI thông thường không có cơ chế suy luận phức tạp lại hoạt động hiệu quả và chính xác hơn so với những "siêu mô hình" được trang bị khả năng suy luận. Điều này giống như việc một học sinh bình thường giải được bài toán cộng trừ nhanh hơn một thiên tài đang cố gắng áp dụng công thức phức tạp không cần thiết.

Ở mức độ phức tạp trung bình, các mô hình suy luận mới bắt đầu thể hiện được giá trị của mình. Khả năng tạo ra những chuỗi suy nghĩ dài giúp chúng giải quyết những vấn đề mà các mô hình thông thường gặp khó khăn. Đây có thể được coi là "vùng ngọt ngào" duy nhất mà các mô hình suy luận thực sự tỏ ra vượt trội.

Tuy nhiên, khi đối mặt với những bài toán thực sự khó, cả hai loại mô hình đều trải qua sự sụp đổ hoàn toàn. Độ chính xác của chúng giảm xuống gần như bằng không, và mặc dù các mô hình suy luận có thể "cầm cự" lâu hơn một chút, cuối cùng chúng cũng gặp phải những giới hạn cơ bản tương tự. Điều này giống như việc cả học sinh giỏi và học sinh bình thường đều không thể giải được những bài toán đại học khi chỉ có kiến thức cấp ba.

Nghiên cứu của Apple được thực hiện trên các mô hình AI suy luận của ChatGPT, Claude, DeepSeek và Gemini

Một phát hiện còn gây sốc hơn nữa là hành vi "phản trực giác" của các mô hình suy luận khi đối mặt với những thách thức ngày càng lớn. Ban đầu, khi bài toán khó hơn, chúng sẽ "suy nghĩ" nhiều hơn, tạo ra những chuỗi lý luận dài hơn. Nhưng khi đến gần điểm sụp đổ, thay vì cố gắng hết sức, các mô hình này lại bắt đầu "lười biếng", giảm nỗ lực suy luận mặc dù vẫn còn rất nhiều tài nguyên tính toán.

Điều này cho thấy chúng như có khả năng "nhận ra" khi nào mình không thể giải quyết và quyết định "từ bỏ" - một hành vi hoàn toàn khác với cách con người vẫn cố gắng đến cùng khi gặp khó khăn.

Những hạn chế của các mô hình suy luận còn được thể hiện qua một thí nghiệm đáng kinh ngạc khác. Ngay cả khi các nhà nghiên cứu cung cấp cho AI một thuật toán giải quyết vấn đề một cách tường minh và chi tiết trong câu lệnh, hiệu suất của chúng vẫn không hề cải thiện. Sự sụp đổ vẫn xảy ra ở đúng những điểm như trước đó. Điều này cho thấy các mô hình AI không thực sự "hiểu" logic hay có khả năng tuân theo các bước suy luận một cách nhất quán mà chỉ đơn thuần dựa vào việc nhận dạng các mẫu đã học.

Sự bất nhất quán trong hiệu suất của AI cũng là một bằng chứng mạnh mẽ khác. Ví dụ, mô hình Claude 3.7 Sonnet có thể thực hiện chính xác hơn 100 nước đi trong trò chơi Tháp Hà Nội phức tạp nhưng lại thất bại chỉ sau 4 nước đi trong một trò chơi River Crossing đơn giản hơn nhiều. Điều này cho thấy hiệu suất của chúng phụ thuộc chủ yếu vào việc đã "nhìn thấy" những mẫu tương tự trong quá trình huấn luyện chứ không phải khả năng suy luận tổng quát.

Thậm chí, độ "dễ vỡ" của các mô hình này còn được thể hiện qua việc chỉ cần thêm một câu không liên quan vào câu hỏi cũng có thể làm giảm hiệu suất tới 65%. Điều này khẳng định rằng chúng hoạt động dựa trên việc nhận dạng mẫu chứ không phải logic thực sự, và những mẫu này có thể dễ dàng bị "nhiễu loạn" bởi những thông tin không cần thiết.

Quan trọng nhất, nghiên cứu của Apple không tìm thấy bằng chứng nào cho thấy các mô hình này thực hiện suy luận logic hay symbolic thực sự. Thay vào đó, chúng hoạt động giống như những "máy ghi âm xác suất", dự đoán từ tiếp theo dựa trên những mẫu đã thấy trong quá trình huấn luyện chứ không "suy ra" câu trả lời từ những nguyên tắc cơ bản. Những chuỗi suy nghĩ dài dòng mà chúng tạo ra có thể trông rất "có vẻ thông minh" nhưng bên dưới không hề có quá trình giải quyết vấn đề logic thực sự.

Cuối cùng, nghiên cứu của Apple đặt ra một câu hỏi lớn về tương lai của AI: Liệu chúng ta có đang quá "phấn khích" về những khả năng hiện tại của các hệ thống này? Và liệu con đường đến AGI có thực sự còn xa vời hơn nhiều so với những dự đoán lạc quan hiện tại? Với những phát hiện này, có lẽ thay vì mơ mộng về một tương lai AI toàn năng sắp đến, chúng ta cần quay về với thực tế và hiểu rõ hơn về những gì các hệ thống AI hiện tại thực sự có thể và không thể làm được.

(Tổng hợp)

Đời sống pháp luật